La discusión en torno a las diferentes formas que puede adoptar el discurso nocivo en línea parece no tener fin: contenido falso, casos de acoso, doxxing, amenazas y ataques causados por racismo, misoginia, transfobia, homofobia y otros tipos de contenido dañino parecen haberse apoderado de internet, en especial de las plataformas de redes sociales.

Sin embargo, las conductas comprendidas dentro del concepto de discurso nocivo pueden ser elusivas y difíciles de definir, dado el delgado límite que demarca los tipos de discurso protegidos por la libertad de expresión y los estrictos parámetros que deben cumplirse para restringir este derecho.

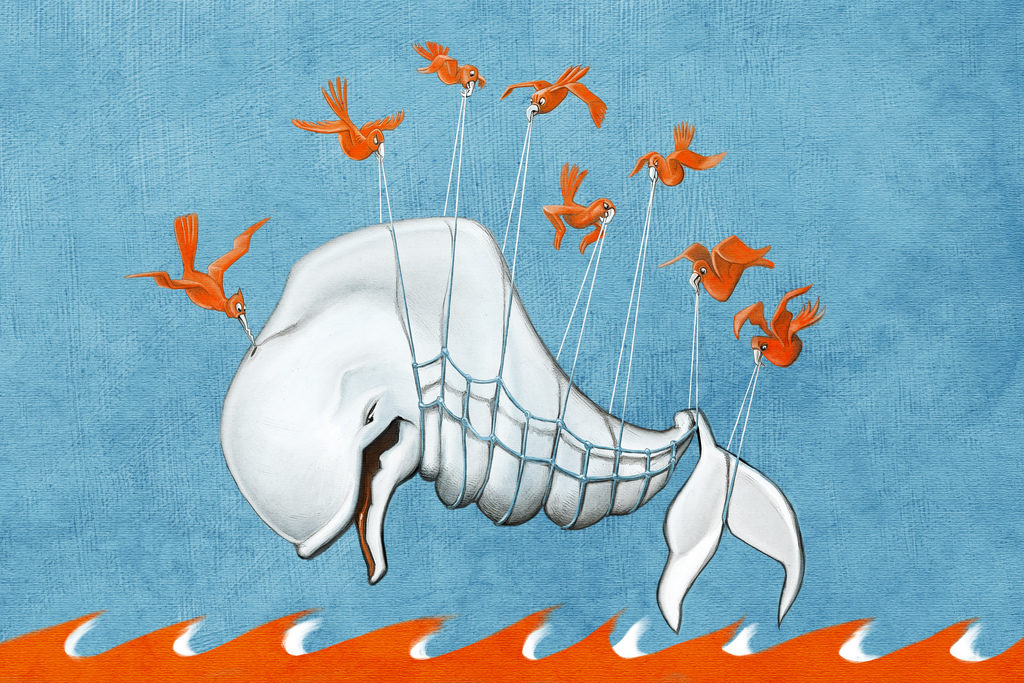

En el centro de la discusión se encuentra el rol de las plataformas, espacios que en su inicio fueron vistos por los más idealistas como herramientas de un inmenso potencial para la masificación del acceso a la información, a la expresión y a la cultura, pero que hoy parecen verse constantemente bajo la acusación de servir de herramientas para causar daño a otras personas e, incluso, de capitalizar el discurso nocivo para ampliar su atractivo como servicio. No es un error, sino una característica: compañías como Facebook, que sustentan su modelo de negocio en la venta de publicidad, se han visto claramente beneficiadas por su implementación de estándares muy diferentes para el contenido publicado por la comunidad y el contenido proporcionado por sus anunciantes.

Compañías como Twitter, Instagram y Facebook administran espacios en los cuales, de manera simultánea, se permiten actos cotidianos de acoso, agresión y doxxing, mientras se censuran contenidos cuyo carácter dañino es altamente cuestionable: Facebook tiene un largo historial de censura de imágenes de mujeres amamantando, mujeres con sobrepeso o imágenes relacionadas con la menstruación. El modelo autorregulatorio parece resultar insuficiente al encontrarnos frente a compañías que responden a intereses económicos; tal como recientemente reportara Forbes, Twitter ignoró durante la mayor parte de su historia el contenido nocivo; solo sus intentos de vender –y el rechazo de varios potenciales compradores, al menos en parte debido al rol de la plataforma como espacio para el discurso de odio- desencadenaron los recientes de invertir fuertemente en medidas para limitar comportamientos abusivos.

Si bien es cierto que, como propietarios y administradores de espacios donde se desarrolla el discurso público, estas compañías tienen responsabilidad en el control de los actos que se cometen en sus plataformas, la capacidad de los intermediarios de internet para limitar el flujo del contenido debe estar sometida a parámetros sumamente estrictos y limitados, puesto que de lo contrario podríamos promover la privatización de la censura.

Frente a este problema, hay quien argumenta que la autorregulación ha funcionado bien por largo tiempo para los medios de comunicación tradicionales. Pero las plataformas en línea no son medios de comunicación tradicionales. Aunque desde un punto de vista estrictamente técnico la plataforma es “neutral”, en la práctica está regulada por algoritmos, políticas de contenido y empleados que toman decisiones con respecto al contenido “permitido”, no bajo lógicas periodísticas, sino lógicas de mercado. Como consecuencia, una determinada plataforma podrá considerar válido contenido que otra prohibirá, de acuerdo con lo que una comunidad considere permisible; lo que una comunidad como 4chan considera aceptable puede ser muy diferente de lo que se considera aceptable en Instagram, y estas plataformas no obedecen parámetros de derechos humanos, sino de masa crítica: lo que importa, en realidad, es optimizar el número de usuarios activos en el servicio, porque ese es el producto que se vende a los anunciantes.

Esto es una constatación del rol que juega la realidad económica frente a la libertad de expresión: tal como hemos visto, la única forma real de influir en cambios sobre los parámetros de contenido considerado aceptable en una plataforma determinada es lograr que un número crítico de usuarios se retire del servicio o conseguir que los anunciantes dejen de contratar publicidad. Fuera de esto, solo queda una última influencia: la posibilidad de los gobiernos de ejercer presión sobre las compañías.

A efectos prácticos, esto genera un ecosistema donde los parámetros del contenido aceptable están sujetos a cambios constantes, lo que por un lado imposibilita a los usuarios estar seguros de que están pisando firme al publicar determinado contenido (generando así un efecto de enfriamiento de la libertad de expresión) y por el otro, lleva a las compañías a restringir mucho más o mucho menos contenido del que sería exigible por ley.

Por último, si bien medidas como la remoción de usuarios falsos podría incrementar la confianza y la seguridad en una comunidad en línea, lo cierto es que las compañías no tienen incentivos económicos para hacerlo. Por el contrario, la meta es obtener más y nuevos usuarios. Al mismo tiempo, la toma de decisiones por la “conciencia colectiva”, como el reporte en masa que llevó al cierre de la cuenta de Al Jazeera en Twitter, a menudo no obedece a la existencia real de contenido nocivo, sino a los influjos de la ciertos sectores de la opinión pública.

Para más inri, en aquellos lugares donde los usuarios no poseen un peso crítico en términos comerciales, las comunidades no cuentan con la fuerza para lograr que sus protestas sean escuchadas: así, Maiol Sanaüja, independentista en oposición al gobierno de Cataluña, vio cerrada su cuenta de Twitter en marzo de este año, sin que ninguna protesta fuera capaz de recuperarla, viéndose forzado a abrir una nueva cuenta.

En última instancia, la mayor parte del acercamiento de las plataformas al contenido abusivo consiste en darlo de baja, una medida que no logra persuadir a las personas de dejar de “pensar, hablar y publicar” contenido dañino, sino que convierte la administración de estas plataformas en un ejercicio de cacería constante. Por un lado, las herramientas existentes para reportar abusos ponen un peso desproporcionado en la víctima, al punto de forzarla con frecuencia a abandonar la plataforma, lo que suele ser el objetivo principal de los atacantes. Por el otro, la búsqueda de herramientas de censura automática y algorítmica tienden a ser desproporcionales.

Cada vez más los estados están presionando a las plataformas de internet a borrar contenido, lo que inevitablemente llevará a la utilización de sistemas automatizados y al exceso de celo por parte de las plataformas que terminará en la restricción de mucho más contenido del que ordenaría, por ejemplo, una autoridad judicial. Para evitar daños irremediables al ecosistema de internet, necesitamos encontrar el balance entre el importante rol de permitir y preservar el discurso incómodo e impopular, y la preservación de espacios seguros para que los usuarios puedan expresarse libremente.

Día Mundial de la Libertad de Prensa

Día Mundial de la Libertad de Prensa Ataques físicos y violencia digital

Ataques físicos y violencia digital Vulnerabilidades que persisten

Vulnerabilidades que persisten